通过NVIDIA GH200 超级服务器

Tensor Core GPU,在每个工作负载中实现出色性能、可扩展性和安全性。使用 NVIDIA NVLink Switch 系统,可连接多达 256 个 H100 来加速百亿亿级 (Exascale) 工作负载,另外可通过专用的 Transformer 引擎来处理万亿参数语言模型。与上一代产品相比,H100 的综合技术创新可以将大型语言模型的速度提高 30 倍,从而提供业界领先的对话式 AI。

GH200配备第四代 Tensor Core 和 Transformer 引擎(FP8 精度),与上一代产品相比,可为多专家 (MoE) 模型提供高 9 倍的训练速度。通过结合可提供 900 GB/s GPU 间互连的第四代 NVlink、可跨节点加速每个 GPU 通信的 NVLINK Switch 系统、PCIe 5.0 以及 NVIDIA Magnum IO? 软件,为小型企业到大规模统一 GPU 集群提供高效的可扩展性。

在数据中心级部署 GH200 GPU 可提供出色的性能,并使所有研究人员均能轻松使用新一代百亿亿次级 (Exascale) 高性能计算 (HPC) 和万亿参数的 AI。

AI 正在利用一系列广泛的神经网络解决范围同样广泛的一系列商业挑战。出色的 AI 推理加速器不仅要提供非凡性能,还要利用通用性加速这些神经网络。

GH200进一步扩展了 NVIDIA 在推理领域的市场领先地位,其多项先进技术可将推理速度提高 30 倍,并提供超低的延迟。第四代 Tensor Core 可加速所有精度(包括 FP64、TF32、FP32、FP16 和 INT8)。Transformer 引擎可结合使用 FP8 和 FP16 精度,减少内存占用并提高性能,同时仍能保持大型语言模型的准确性。

VIDIA 数据中心平台性能持续提升,超越摩尔定律。GH200的全新突破性 AI 性能进一步加强了 HPC+AI 的力量,加速科学家和研究人员的探索,让他们全身心投入工作,解决世界面临的重大挑战。

GH200使双精度 Tensor Core 的每秒浮点运算 (FLOPS) 提升 3 倍,为 HPC 提供 60 teraFLOPS 的 FP64 浮点运算。融合 AI 的高性能计算应用可以利用 H100 的 TF32 精度实现 1 petaFLOP 的吞吐量,从而在不更改代码的情况下,实现单精度矩阵乘法运算。

GH200超微NV服务器还采用 DPX 指令,其性能比 NVIDIA A100 Tensor Core GPU 高 7 倍,在动态编程算法(例如,用于 DNA 序列比对 Smith-Waterman)上比仅使用传统双路 CPU 的服务器快 40 倍。

公司业务范围

电力和自动化(ABB)

分散控制系统(DCS)

可编程序控制器(PLC)

数据采集及监视控制系统(SCADA)

安全仪表系统(SIS)

MOTOROLA MVME 工业用模组

压缩机组控制系统(CCS)等各类工控系统部件

提供紧急备件支持 品种齐全 可为用户定制备件储备

多种类现货库存 响应速度快 减少用户资本投入,提高备件利用率

库存现货 还有很多未上架的库存 欢迎来电咨询

福建众创高电气设备有限公司

售前热线(同V):15359273790蒋经理

售前热线(同V):18060908697林经理

欢迎来电咨询

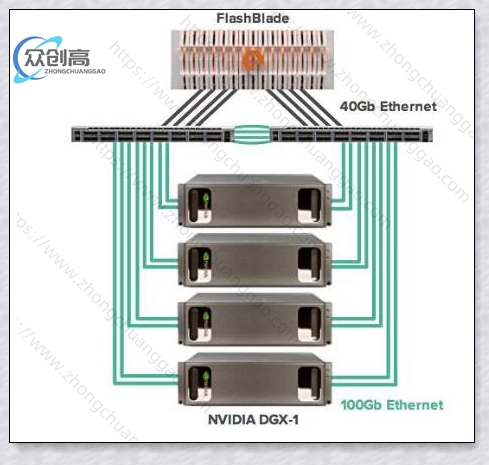

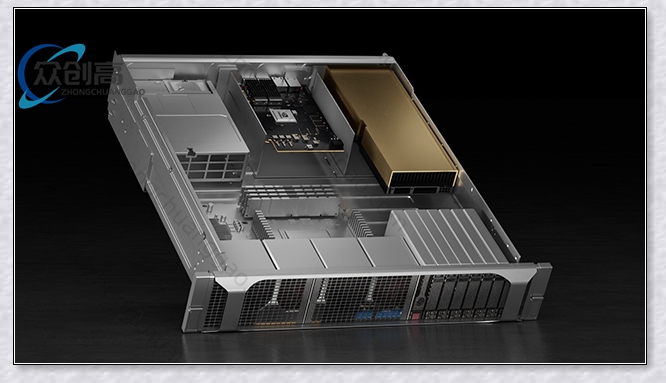

NVIDIA H100 超微NV服务器

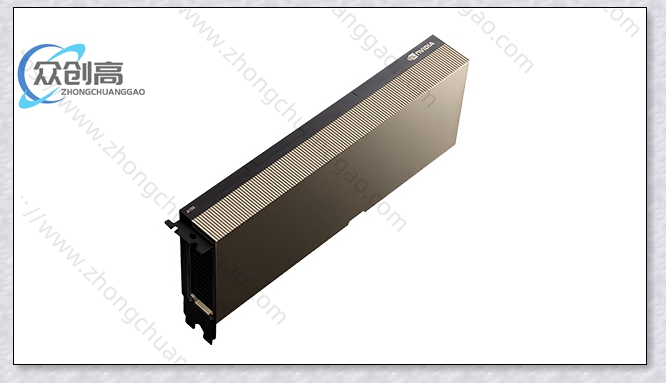

NVIDIA H100 超微NV服务器  NVIDIA H100 PCIE 单卡

NVIDIA H100 PCIE 单卡  NVIDIA H800超微NV服务器

NVIDIA H800超微NV服务器